【WRC ? 前沿】達芬奇機器人變身‘模仿達人’,通過看視頻模仿手術縫合、穿針、打結等動作

時間:2020-07-03

模仿是最原始的學習方法,也是實現人工智能的基石。

通過深度學習和算法,機器人也可以通過看視頻學會各種各樣的技能。

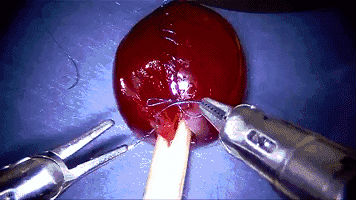

先看個圖:

是不是覺得有點眼熟。

沒錯,它就是技藝高超,被大家所熟知的達芬奇機器人。

這次它又被賦予了新功能:通過觀看教學視頻,學會外科手術中的相關任務。比如縫合,穿針,以及打結等動作。

讓達芬奇機器人變成‘模仿藝人’的關鍵,是一個叫做Motion2Vec的半監督式學習算法,近日由谷歌大腦,英特爾公司和加利福尼亞大學伯克利分校合作開發。

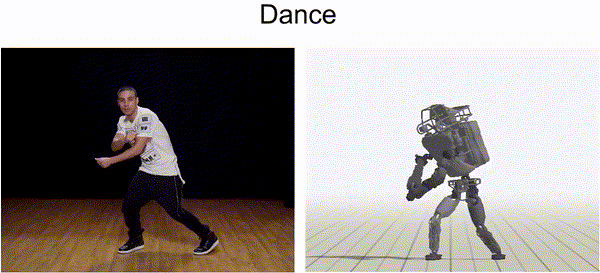

起初,加州大學伯克利分校的教授曾使用YouTube視頻作為機器人學習各種動作(例如跳躍或跳舞)的指南。機器人模仿視頻中的動作,成功學習了20多種雜技,比如側空翻、單手翻、后空翻等高難度動作。

谷歌此前也有過相關研究,例如使用視頻來教授四足機器人學習狗狗的靈活動作。

這些經歷促成了他們彼此的合作,他們將這些知識應用于最新項目Motion2Vec中,在這個過程中,使用了實際手術過程的視頻進行指導和訓練。

在最近發布的論文中,研究人員概述了他們如何使用YouTube視頻訓練兩臂的達芬奇機器人在織布機上插入針頭并進行縫合。

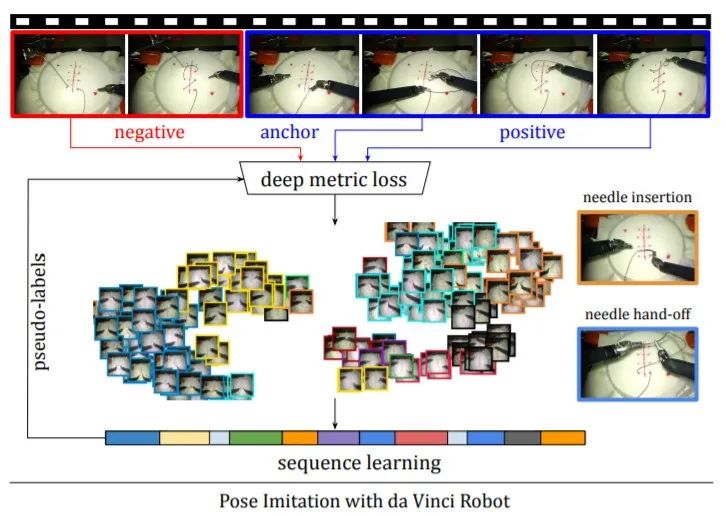

人類在看視頻的時候可以迅速理解內容,但機器人目前無法做到這一點,它們只是將其視為像素流。因此,要以機器人的方式讓他們理解并學習——弄清并分析這些像素,然后將視頻分割成有意義的序列。

事實上,Motion2Vec算法的開發主要基于暹羅網絡和遞歸神經網絡。

暹羅網絡(Siamesenetwork)就是“連體的神經網絡”,神經網絡的“連體”是通過共享權值來實現的。它的主要功能是衡量兩個物體的相似度。比如,看看某兩個人長得像不像。

這樣,研究人員就可以將視頻中相同動作段的圖像放到一起,并給它們做一個標記,比如‘針頭插入’,或‘瞄準位置’等,從而對視頻中的圖像進行分割和分類。

然后,研究人員使用遞歸神經網絡來找到那些沒有被標記的圖像,這些圖像會反饋到暹羅網絡中以改善動作片段的比對。

對于縫合任務,研究團隊僅需要78個教學醫學視頻即可訓練其AI引擎執行該過程,成功率為85%。

這似乎意味著機器人可以在外科手術中承擔一些更基本,重復性的任務,但它們目前還無法完全代替醫生來做手術。

加州大學伯克利分校實驗室的負責人KenGoldberg解釋說“我們想要看到的是,機器人在做基本縫合任務,而外科醫生能夠監視手術過程,比如像機器人表明他們想要在哪一排進行縫合,或傳達出希望進行六次覆膜縫合的想法。” “這樣,機器人能代替外科醫生做最基本的任務,讓醫生們得到更多的休息,并能夠專注于手術中更復雜或更細微的部分。”

(來源:機器人大講堂公眾號)